© 2024 Валерия Николаевна СОКОЛЬЧИК, Алексей Иванович РАЗУВАНОВ, Лина Сергеевна НАВИЦКАЯ

МАиБ 2024 – № 1(27)

DOI: https://doi.org/10.33876/2224-9680/2024-1-27/02

Ссылка при цитировании: Сокольчик В.Н., Разуванов А.И., Навицкая Л.С. (2024) Доверие пациента к применению искусственного интеллекта в медицине как новый этический вызов, Медицинская антропология и биоэтика, № 1(27).

Валерия Николаевна Сокольчик –

Валерия Николаевна Сокольчик –

кандидат философских наук,

рук. Республиканского центра биоэтики,

доцент каф. организации здравоохранения Института повышения квалификации и переподготовки кадров здравоохранения Белорусского гос. медицинского университета

(Минск, Республика Беларусь)

https://orcid.org/0000-0002-4975-4052

E—mail: vsokolchik@mail.ru

кандидат медицинских наук,

ученый секретарь ГУ

«Республиканский научно-практический центр медицинской экспертизы и реабилитации»

.

(Минск, Республика Беларусь)

.

https://orcid.org/0000-0001-5033-2933

E—mail:doc-rai@yandex.by

.

сотрудница Республиканского центра биоэтики,

магистрантка факультета философии и социальных наук

Белорусского государственного университета

.

(Минск, Республика Беларусь)

.

E—mail:

polina.navitskaya@mail.ru

Ключевые слова: доверие пациента; ответственность; искусственный интеллект; здравоохранение; система здравоохранения; этико-правовые рекомендации; этическое сопровождение

Аннотация. Один из самых сложных вызовов применения искусственного интеллекта в современном здравоохранении – это доверие пациентов (и самих медицинских работников) к его использованию. Формирование доверия к искусственному интеллекту (далее – ИИ) складывается из многих факторов, где в числе наиболее значимых нужно назвать преодоление страхов и неуверенности в ИИ, опору на его правовое и этическое регулирование и разрешение вопросов ответственности за ошибки. Огромную роль в решении всех поставленных вопросов играет этическое сопровождение ИИ на всех этапах его создания, обучения и применения. На основании проведенного исследования, включавшего в том числе интервьюирование и опросы представителей системы здравоохранения, специалистов информационной сферы, педагогов, пациентов, ученых и т.д., авторы заключают, что реализация мер этико-правовой регламентации использования ИИ, создание экспертных и консультативных социально-этических структур для сопровождения использования ИИ, формирование этических требований к взаимодействию с ИИ и просвещение общества по поставленной проблеме – основные задачи и ступени формирования доверия общества к применению ИИ в медицине.

Введение

Один из самых сложных вызовов искусственного интеллекта заключается в ответе на вопрос: можем ли мы доверять ИИ? Доверие традиционно рассматривают как открытые взаимоотношения между людьми (либо между человеком и субъектом), содержащие уверенность в порядочности другого человека (субъекта), с которым доверяющий находится в тех или иных отношениях (Гайдук 2017).

Формирование ощущения доверия другому человеку (сообществу) – процесс достаточно сложный, неоднозначный, связанный с феноменами веры, ответственности, ценностей, понимания и т.д. Соответственно, вопрос доверия ИИ выходит за рамки традиционного восприятия понятия «доверие», поскольку здесь проблематизация взаимоотношений затрагивает взаимодействие с искусственным разумом, обладающим совершенно иными характеристиками, нежели человек, и, кроме того, не артикулирующим человеческую систему ценностей.

Особое значение доверие ИИ приобретает в системе здравоохранения, где использование систем ИИ возрастает с каждым днем и определяет «лицо» современной медицины. Здесь мы имеем в виду «нагруженность» медицины информационными технологиями – в сфере скрининга и анализа данных, работу с медицинскими изображениями, использование ИИ для проведения сложнейших манипуляций, организацию менеджмента здравоохранения, отслеживание состояния и динамики здоровья пациентов (через специальные девайсы и программы) и т.д.

Эффективность ИИ в медицине сложно отрицать. Положительный эффект его применения основывается на том, что он способен обрабатывать большой массив информации в сжатые сроки, что также может улучшить и облегчить деятельность человека и минимизировать количество ошибок. Так, по данным компании Deloitte (DeloitteToucheTohmatsuLimited 2023), сегодня искусственный интеллект входит в десятку лучших инноваций в сфере здравоохранения; компания USM Systems в своем исследовании утверждает, что до 50% международных медицинских организаций запланировали внедрить элементы искусственного интеллекта к 2025 г. (United States Cellular Corporation (USM) 2022). Согласно статистике, элементы ИИ в области здравоохранения чаще всего используются для помощи в диагностике и управлении процессами (United States Cellular Corporation (USM) 2022). Огромную помощь, оказываемую ИИ здравоохранению, представляет также работа с медицинской документацией, переведенной в цифровой формат, консультирование пациентов в режиме онлайн.

Медицинские информационные системы, построенные на основе алгоритмов ИИ, не только позволяют анализировать большие объемы данных, обрабатывая их статистически, но также упрощают принятие управленческих решений в организациях здравоохранения, обеспечивают контроль финансовых затрат на лечение и реабилитацию пациентов, алгоритмизируют организацию медицинских исследований, аккумулируют вспомогательную информацию в учреждениях здравоохранения.

Вместе с тем все эти безусловные преимущества развития системы здравоохранения при применении ИИ порождают большое количество вопросов, связанных с этико-правовыми установками использования ИИ и его обучения, с формированием продуманной системы применения ИИ в здравоохранении и созданием новой триады взаимоотношений «медицинский работник – ИИ – пациент», основанной на ответственности, этическом контроле и, главное, доверии.

Во многом именно доверие определяет нашу готовность взаимодействовать с ИИ, устанавливать ограничения для его использования, выстраивать механизмы контроля, и, в конечном итоге, принимать результаты и выводы, предложенные ИИ. В паттерне взаимоотношений человека и ИИ доверие становится основой сотрудничества и фундаментом для дальнейшего развития ИИ.

Основные результаты проведенных опросов по изучению этического сопровождения ИИ

В рамках проекта Республиканского центра биоэтики1 по изучению этического сопровождения ИИ наряду с анализом литературы и законодательных документов по рассматриваемой теме авторами настоящей статьи было проведено интервьюирование представителей медицинского исследовательского сообщества, членов независимых этических комитетов (НЭК), инженеров-программистов; организованы анонимные пилотные опросы представителей системы здравоохранения, специалистов IT-сферы, ученых, преподавателей, а также обучающихся об использовании ИИ в медицине, науке, образовании и возникающих новых этических вызовах. В рамках обозначенной темы были подготовлены и осуществлены конференции и вебинары совместно со странами СНГ.

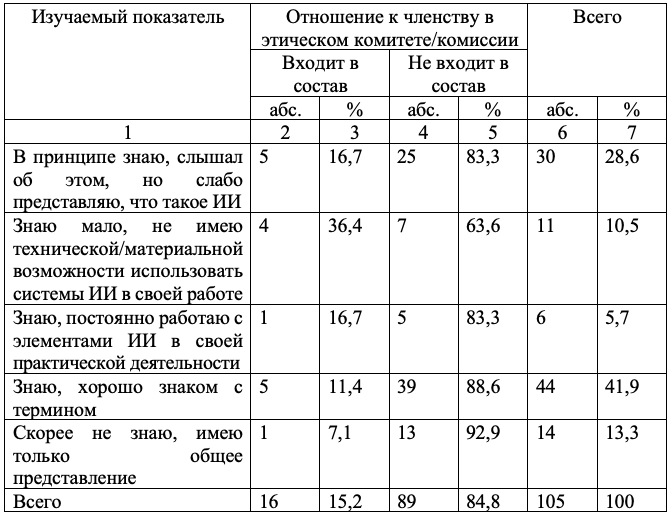

Первый опрособ использовании ИИ в медицине и этических проблемах, возникающих в связи с этими перспективами, проводился в январе–марте 2023 г., в котором в общей сложности приняли участие 105 человек (был применен метод «снежного кома»).

Среди респондентов преобладали лица женского пола – 75,2% опрошенных, по профессиональной принадлежности включавшие научных сотрудников (87,5%), преподавателей (74,1%), врачей-специалистов (63,0%).

Большинство опрошенных находились в возрастном промежутке от 26 до 55 лет со следующим внутренним распределением: 26–35 лет – 36 (34,3%) человек, 36–45 лет – 29 (27,6%) человек, 46–55 лет – 23 (21,9%) человека. 16 респондентов (15,2%) указали, что являются членами НЭК (Разуванов, Сокольчик 2023) (рис. 1).

* Таблица составлена на основании данных статьи: Разуванов А.И., Сокольчик В.Н. (2023) Этические вызовы применения элементов искусственного интеллекта в медицине и медицинских исследованиях, Вопросы организации и информатизации здравоохранения, № 2, с. 84–95.

**категория «иные» подразумевает следующих специалистов: учащийся, безработный, психолог, социальный работник, главный специалист отдела статистики, эмбриолог, библиотекарь, медицинский представитель, специалист колл-центра, аудитор.

Второй опрос «ChatGPT и другие инструменты генеративного искусственного интеллекта: влияние на современное образование и науку» проводится с июня 2024 г., также с применением метода «снежного кома», по данным на ноябрь 2024 г. в нем приняли участие 130 человек. Среди респондентов преобладают лица женского пола (65,5%), по профессиональной принадлежности состоящие из ученых/исследователей (33,6%), преподавателей (28,2%), медицинских работников (21,8%). Большинство опрошенных находятся в возрастном промежутке от 18 до 55 лет со следующим внутренним распределением: 18–25 лет – 23 (20,9%) человека, 26–35 лет – 21 (19,1%) человек, 36–45 лет – 33 (30,0%) человека, 46–55 лет – 20 (18,2%) человек, 5 респондентов (4,5%) указали, что являются членами НЭК.

В целом, на основании приведенных в опросах мнений респондентов, а также с учетом интервьюирования специалистов и дискуссий на вебинарах, посвященных этическому сопровождению ИИ в науке и образовании, проводимых Республиканским центром биоэтики в 2024 г., можно сделать вывод о том, что уровень доверия ИИ как в медицине, так и в науке/образовании недостаточно высок.

Среди наиболее частых проблем использования ИИ, отражающих недоверие пользователей, участники первого опроса об применении ИИ в медицине отмечали актуальность ошибок ИИ, были обеспокоены обеспечением конфиденциальности данных пациентов при использовании ИИ, отмечали важность оценки влияния дискриминации при применении ИИ (например, разный уровень знаний испытуемых) и т.д. Комментарии респондентов: «список вопросов, полагаю будет, расти в геометрической прогрессии» и «необходимо определить предел “компетенций” ИИ в медицине – что может и чего не может делать ИИ», на наш взгляд, также подчеркивают некоторую тревогу и недоверие к использованию ИИ в медицине (Разуванов, Сокольчик, 2023).

В опросе, посвященном влиянию генеративного ИИ на науку и образование, респонденты также отмечают негативные факторы, связанные с использованием ИИ, – такие как снижение достоверности научных исследований (41,4%), проблемы с научной честностью (42,9%), снижение креативности мышления ученых, преподавателей, обучающихся (32,9%), а также рост плагиаризма, ошибки и галлюцинации ИИ, недоверие к полученным с помощью ИИ данным и т.д.

В целом, причин недоверия к ИИ может быть названо несколько. Прежде всего, недоверие связано с недостаточным уровнем понимания, что же такое ИИ. В рамках пилотного опроса, посвященного использованию ИИ в медицине, респонденты преимущественно обозначали ИИ как «Технологии, имитирующие (моделирующие) мыслительные функции человека», «Машины или программы, обеспечивающие решения необходимых задач», «Искусственный аналог человеческого интеллекта».

По мнению авторов, отсутствие четкой артикуляции и понимания классификации систем ИИ в общественном дискурсе порождает ощущение неуверенности, невключенности в систему взаимодействия с ИИ и, соответственно, недоверие пользователей (в контексте здравоохранения – как медицинских работников, так и пациентов).

В свою очередь, «разночтения» в понимании ИИ не позволяют адекватно и единообразно проводить экспертизу медицинских научных исследований с использованием ИИ членами этических комитетов. Решением данной проблемы является дополнительное обучение специалистов, проводящих медицинские исследования и осуществляющих их экспертизу, – т.е. необходимы специализированные семинары/воркшопы/круглые столы о современных исследованиях по применению элементов ИИ в медицине, о существующей этико-правовой базе в отношении ИИ, новых подходах и преимуществах использования ИИ в исследованиях для аспирантов и докторантов, врачей-специалистов, членов НЭК.

Так, большинство респондентов в ходе нашего первого опроса отметили, что «слышали об ИИ» (86,7%), но только шесть (5,7%) респондентов ответили, что «знают и постоянно работают с элементами ИИ в своей практической деятельности».

* Таблица составлена на основании данных статьи: Разуванов А.И., Сокольчик В.Н. (2023) Этические вызовы применения элементов искусственного интеллекта в медицине и медицинских исследованиях, Вопросы организации и информатизации здравоохранения, № 2, с. 84–95.

Опираясь на данные пилотного опроса и интервьюирования специалистов, авторы констатируют наличие проблемы понимания сущности ИИ в медицинской среде (как, впрочем, и в обществе в целом). Безусловно, понимание варьируется в зависимости от уровня знаний и опыта в сфере информационных технологий, что, в целом, являлось ожидаемым. Далеко не все опрошенные видят в ИИ потенциал для автоматизации работы систем здравоохранения и улучшения их производительности, включая потенциал ИИ для проведения медицинских исследований и соответствующего обучения. В то же время многие респонденты обозначают ИИ как возможную угрозу для рабочих мест и безопасности данных. Так, в рамках проводимого в данный момент опроса о влиянии генеративного ИИ на образование и науку, большая часть респондентов (77,6%) считает, что серьезной проблемой для социума и человека станет ошибочная информация, предлагаемая ИИ, а 49,3% респондентов считают, что генеративный ИИ оказывает существенное негативное влияние на развитие науки.

Проблему непонимания ИИ и, как следствие, недоверия к нему обозначил еще в 70-е годы прошлого века японский ученый Масахиро Мори (Mori, MacDorman, Kageki 2012), определив ее как «феномен зловещей долины» (uncanny velley). В этом феномене был зафиксирован страх людей перед антропоморфными роботами и ИИ, проявляющим признаки человеческого интеллекта. Несмотря на значительный промежуток времени, отделяющий нас от высказывания Мори, ситуация не становится более сбалансированной, скорее наоборот, колоссальные темпы развития и использования систем ИИ на практике при недостаточности просвещения пользователей по этому вопросу, по прежнему вызывают страх, непонимание и недоверие у значительной части населения.

Еще одна важная причина недоверия к применению ИИ в здравоохранении – это достаточно частые ошибки и галлюцинации ИИ (в том числе ошибки, которые в профессиональной сфере могут привести к трагическим последствиям), ложь и заблуждения, которые ИИ нередко продуцирует в ответ на запросы человека, предубеждения ИИ (связанные с особенностями представлений разработчиков, некорректным использованием баз данных и отсутствием учета социокультурных особенностей среды, где будут применяться системы ИИ), непрозрачность предоставляемых ИИ выводов (результатов) и т.д.

Безусловно, многие основания недоверия к ИИ будут со временем «сниматься», вследствие развития последнего, однако, во-первых, с расширением нашего постоянного взаимодействия с ИИ будут появляться новые проблемы и вызовы доверия, и, во-вторых, в отсутствие внимания к проблеме и в отсутствие потребности ее решать, феномен «зловещей долины», вероятно, будет прогрессировать в общественном и индивидуальном сознании (Fisher, Gillespie, Malta, Gobbi 2023).

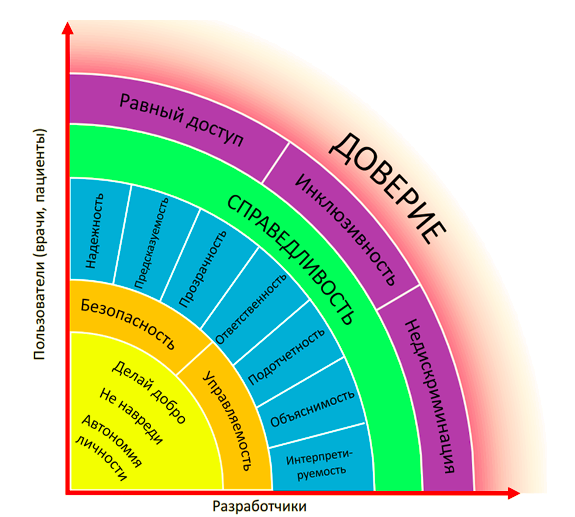

Непонимание сущности ИИ усиливается недостаточностью его этико-правового сопровождения и регулирования. Это – еще одна базовая причина недоверия к ИИ. В контексте системы здравоохранения пациенты (равно как медицинские работники) должны быть уверены, что сформирована система ответственности за действия и решения ИИ, что этические принципы и правила современной медицины (начиная от принципов современной биомедицинской этики – автономия личности, справедливость, принципы «не навреди» и «делай добро»), ее базовые ценности (ценность человеческой жизни и ценность улучшения ее качества) заложены в основу обучения ИИ.

Сегодня обществу необходимы этико-правовые стандарты и рекомендации, обеспечивающие взвешенное и взаимообусловленное сотрудничество в системе взаимоотношений «разработчик ИИ – ИИ – пользователь ИИ». Необходимо понимать, что такие стандарты могут опираться, скорее, на этические нормы регулирования взаимоотношений, нежели на жесткие нормы права. Это связано со скоростью развития ИИ и технологий его разработок и непредсказуемостью путей совершенствования и распространения ИИ. По мнению авторов, наиболее приемлемым путем регулирования взаимодействия ИИ с человеком в контексте доверия последнего к искусственному интеллекту являются этико-правовые рекомендации и общая регламентация принципов взаимодействия.

В ряду наиболее общих уже действующих документов, регулирующих развитие, обучение и взаимодействие с ИИ, можно назвать этические рекомендации Международной коалиции регуляторных органов в области лекарственных средств (ICMRA) для сфер клинической медицины и фармацевтики 2021 г. (ICMRA 2021); рекомендации по этике использования ИИ Юнеско 2021 г. (UNESCO 2021), руководство ВОЗ (WHO) по этике и управлению использованием Искусственного интеллекта в здравоохранении 2021 г. (WHO 2021), российский кодекс этики искусственного интеллекта (Альянс в сфере искусственного интеллекта (Россия) 2022), Билль о правах ИИ США (The White House 2022) и утвержденный в мае 2024 г. Регламент использования ИИ (Artificial Intelligence Act) Европейского союза (далее – Регламент) (Европейский Союз 2024).

Регламент, подготовленный в 2024 г., аккумулирует и классифицирует наиболее значимые идеи и подходы к работе с ИИ, обозначенные в вышеперечисленных документах. Авторы регламента, определяя цели создания соответствующего документа, отмечают значимость ограничений ИИ в контексте его влияния на человека и общество и в контексте формирования доверия общества к ИИ. Акцентируется, что регламент нацелен на уважение свободы науки и развитие ИИ, «очерчивает» общие направления и этические рамки такого развития.

Так, в Регламенте ИИ, обозначены три группы систем ИИ и общие установки их регулирования (Европейский Союз 2024).

Первую группу составляют «запрещенные системы», которые воздействуют на подсознание человека, могут «вычислять» слабые стороны социальных групп, взаимоотношений, человеческой личности и т.д., а также системы ИИ, которые осуществляют разного рода социальную оценку, выработку критериев распределения и принимают соответствующие решения. Такие системы должны быть взяты под постоянный контроль общественных структур (включая и профессиональные службы), требуют применения достаточно жестких ограничений вплоть до полного запрещения (ограничения) соответствующих исследований.

Вторую группу составляют системы высокого риска, где вероятность причинения ущерба, несправедливого распределения и т.д. достаточно велика. По мнению разработчиков документа, использование таких систем может привести к дискриминации и стигматизации в обществе, установлению несправедливых систем распределения и другим неблагоприятным последствиям для социума. С системами высокого риска мы сталкиваемся в сфере финансов, медицины, правосудия, при организации доступа к значимым ресурсам – таким как электричество, телекоммуникации и др. Типичный пример – сортировка пациентов для неотложной медицинской помощи (например, в ситуации катастроф, пандемий и проч.), которая при отсутствии этического обучения ИИ (а также разработчика) может привести не только к «механистическому» подходу к человеку, но и к летальным исходам, которых можно было бы избежать, и даже к разрушению ценностей нашей цивилизации. По мнению авторов, к таким системам сегодня уже можно отнести и некоторые системы генеративного ИИ, которые оказывают значимое негативное влияние на образование, науку, искусство. В ходе изучения систем высокого риска (с точки зрения их воздействия на человека), в контексте приоритетной социальной и личностной коммуникации с ИИ также могут формироваться проблемы эмоциональной зависимости от ИИ, разрушения социальной адаптации, потери адекватного восприятия реальности. Особенностями работы с системами ИИ высокого риска, реализация которых может обеспечить доверие общества, являются:

– требование использования систем ИИ с учетом предполагаемой цели создания;

– непрерывная система управления рисками на протяжении всего жизненного цикла;

– постоянный мониторинг взаимодействия ИИ с человеком и со средой;

– адекватное обозначение (в т.ч. в качестве инструктажа) любых возможных рисков целевого и нецелевого использования ИИ;

– необходимость социально-этической экспертизы систем ИИ;

– обучение ИИ с использованием высококачественных данных, обязательное использование при обучении ИИ этических регулятивов (принципы, ценности, нормы).

Особую значимость в контексте систем высокого риска приобретает постоянный контроль и экспертиза решений, принимаемых ИИ, и, по возможности, использование этих решений только в статусе рекомендаций.

Третья группа систем ИИ, обозначенная в Регламенте, – это системы низкого риска, которые не оказывают значимого негативного воздействия на пользователей. Однако, в свете решения проблемы доверия общества, разработчики Регламента акцентируют обязательность информирования пользователей о том, что он взаимодействуют с ИИ даже при отсутствии видимых рисков (например, при анонимном анкетировании или опросе). Своевременное получение адекватной правдивой информации о взаимодействии с ИИ, по мнению авторов – это также одно из условий формирования доверия общества к использованию ИИ.

К сожалению, на сегодня среди примеров этико-правовой регламентации использования ИИ не так много документов (международного и национального характера), которые непосредственно касались бы применения ИИ в здравоохранении. Обращает на себя внимание и тот факт, что в Республике Беларусь значимые этико-правовые документы, регулирующие применение ИИ в здравоохранении (и других сферах жизни общества) пока отсутствуют.

Наряду с регламентами взаимодействия с ИИ необходимо также и принятие единых этических принципов его использования, на основании которых можно выстраивать этические рекомендации по работе с системами ИИ, а также организовывать этическое обучение ИИ. Авторами были разработаны этические принципы (Сокольчик, Разуванов 2024), а также на их основании подготовлен чек-лист для исследователей и этических комитетов, осуществляющих соответствующую экспертизу системы здравоохранения. Эти идеи и наработки можно использовать для подготовки соответствующих документов, регламентов и рекомендаций по использованию ИИ в здравоохранении. Тезис о важности этического сопровождения ИИ поддерживают 85,5% респондентов, предоставивших ответы в рамках опроса о влиянии генеративного ИИ на науку и образование.

Выводы

Таким образом, реализация мер этико-правовой регламентации использования ИИ, создание экспертных и консультативных социально-этических структур для сопровождения использования ИИ, этическое обучение ИИ и формирование этических требований к взаимодействию с ИИ, вкупе с всеобщим информированием, общественным обсуждением поставленного вопроса, образованием и просвещением общества – это основные ступени формирования доверия общества и индивида к использованию ИИ.

Важно отметить, что решение проблемных вопросов, связанных с использованием (совершенствованием) ИИ в медицине и здравоохранении должно быть междисциплинарным практически на всех ступенях жизненного цикла ИИ, поскольку междисциплинарность позволяет объединить усилия специалистов в области создания ИИ, специалистов профессиональной сферы, для которой разрабатывается система ИИ, а также специалистов в области этики, права, психологии и т.д., которые обеспечивают адаптацию ИИ для работы в социуме и адаптацию человека к работе с ИИ.

Необходимым шагом для развития ИИ и, соответственно, для развития научных исследований с использованием ИИ является создание на основе этических принципов работы с ИИ нормативно-правовой базы, определяющей ответственность, права и обязанности сторон – участников процесса разработки и использования ИИ.

Просвещение общества в отношении ИИ, постоянное обучение работе с ИИ участников процесса научных исследований служит необходимым фундаментом развития сбалансированных взаимоотношений между пользователями ИИ (пациентами и медицинскими работниками), его разработками и, собственно, искусственным интеллектом.

Важная роль как при проведении исследований с использованием ИИ, так и при контроле применения ИИ в практическом здравоохранении должна отводиться этическим комитетам, комиссиям (или иным этическим структурам). Обеспечивая в медицинских исследованиях их этическую экспертизу, контролируя защищенность человека при работе с ИИ, включая защищенность от ошибок, галлюцинаций и предубеждений, соответствующие этические структуры могут стать «проводниками» доверия человека искусственному интеллекту.

Примечания

1См.: https://www.youtube.com/channel/UCSvQ4Nts3s1bDU1faM4PxXg

Библиография

Алексеева М.Г., Зубов А.И., Новиков М.Ю. (2022) Искусственный интеллект в медицине, Международный научно-исследовательский журнал, № 7 (121), с. 10–13.

Альянс в сфере искусственного интеллекта (2022) Кодекс деятельности ИИ (Россия, 2022). (https://ethics.a-ai.ru) (01.12.2023).

Гайдук А.Б. (2017) Доверие в бизнесе: восприятие общественностью, Известия Санкт-Петербургского государственного экономического университета, вып. 5 (107), с. 87–95.

Европейский Союз (2024) Регламент Европейского союза об искусственном интеллекте. Анализ основных положений и принципов регулирования/EU (2024). (https://ai.gov.ru/knowledgebase/dokumenty-po-razvitiyu-ii-v-drugikh-stranakh/2024_reglament_evropeyskogo_soyuza_ob_iskusstvennom_intellekte_ano_cifrovaya_ekonomika) (10.09.2024).

Разуванов А.И., Сокольчик В.Н. (2023) Этические вызовы применения элементов искусственного интеллекта в медицине и медицинских исследованиях, Вопросы организации и информатизации здравоохранения, № 2, с. 84–95.

Сокольчик В.Н., Разуванов А.И. (2024) Этические принципы использования искусственного интеллекта в исследовательской практике (на примере биомедицинских исследований, Известия Национальной академии наук Беларуси, Серия гуманитарных наук, т. 69, № 2, с. 95–107.

Mori, M., MacDorman, K.F. and Kageki, N. (2012) The Uncanny Valley, IEEE Robotics and Automation Magazine, 19, 98–100.

The White House (2022) Blueprint for an AI Bill of Rights. (https://www.whitehouse.gov/ostp/ai-bill-of-rights/) (15.09.2024).

Fisher, R., Gillespie, N., Malta, J., Gobbi, L. (2023) Trust in artificial intelligence: Global study on the shifting public perceptions of AI, KPMG , (https://assets.kpmg.com/content/dam/kpmgsites/xx/pdf/2023/09/trust-in-ai-global-study-2023.pdf.c oredownload.inline.pdf) (15.09.2024).

WHO (2021) WHO Guidance Ethics and Governance of Artificial Intelligence for Health. (https://www.who.int/publications/i/item/9789240029200) (15.09.2024).

UNESCO (2021) Recommendation on the ethics of artificial intelligence. (https://unesdoc.unesco.org/ark:/48223/pf0000380455.locale=en) (15.09.2024).

ICMRA (2021) Horizon Scanning Assessment Report – Artificial Intelligence in medicine regulation. (https://www.ema.europa.eu/en/news/artificial-intelligence-medicine-regulation) (15.09.2024).

Deloitte Touche Tohmatsu Limited (2023) Top 10 health care innovations. (https://www2.deloitte.com/us/en/pages/life-sciences-and-health-care/articles/top-10-health-care-innovations.html) (15.09.2024).

United States Cellular Corporation (USM) (2022) Top 5 AI Use Cases in Pharma & BioMedicine. (https://usmsystems.com/ai-in-pharma-and-biomedicine) (15.09.2024).

References

Alekseeva, M.G., Zubov, A.I., Novikov, M.Ju. (2022) Iskusstvennyj intellekt v medicine [Artificial intelligence in medicine], Mezhdunarodnyj nauchno-issledovatel’skij zhurnal [International Research Journal], No. 7 (121), p. 10–13.

Al’jans v sfere iskusstvennogo intellekta [Alliance for Artificial Intelligence] (2022) Kodeks dejatel’nosti II (Rossija, 2022) [AI Code of Conduct (Russia, 2022)]. (https://ethics.a-ai.ru) (01.12.2023).

Gajduk, A.B. (2017) Doverie v biznese: vosprijatie obshhestvennost’ju [Trust in business: public perception], Izvestija Sankt-Peterburgskogo gosudarstvennogo jekonomicheskogo universiteta [Proceedings of the St. Petersburg State University of Economics], No. 5 (107), p. 87–95.

Evropejskij Sojuz [European Union] (2024) Reglament Evropejskogo sojuza ob iskusstvennom intellekte. Analiz osnovnyh polozhenij i principov regulirovanija/EU (2024). [European Union Regulation on Artificial Intelligence. Analysis of the main provisions and principles of the Regulation/EU (2024)] (https://ai.gov.ru/knowledgebase/dokumenty-po-razvitiyu-ii-v-drugikh-stranakh/2024_reglament_evropeyskogo_soyuza_ob_iskusstvennom_intellekte_ano_cifrovaya_ekonomika) (10.09.2024).

Razuvanov, A.I., Sokol’chik, V.N. (2023) Jeticheskie vyzovy primenenija jelementov iskusstvennogo intellekta v medicine i medicinskih issledovanijah [Ethical Challenges of Applying Artificial Intelligence Elements in Medicine and Medical Research], Voprosy organizacii i informatizacii zdravoohranenija [Issues of organization and informatization of health care], No. 2, p. 84–95.

Sokol’chik, V.N., Razuvanov, A.I. (2024) Jeticheskie principy ispol’zovanija iskusstvennogo intellekta v issledovatel’skoj praktike (na primere biomedicinskih issledovanij [Ethical principles of using artificial intelligence in research practice (on the example of biomedical research)], Izvestija Nacional’noj akademii nauk Belarusi, Serija gumanitarnyh nauk [Proceedings of the National Academy of Sciences of Belarus, Series of Humanities], vol. 69, No. 2, p. 95–107.

Mori, M., MacDorman, K.F. and Kageki, N. (2012) The Uncanny Valley. IEEE Robotics and Automation Magazine, 19, 98–100.

The White House (2022) Blueprint for an AI Bill of Rights. (https://www.whitehouse.gov/ostp/ai-bill-of-rights/) (15.09.2024).

Fisher, R., Gillespie, N., Malta, J., Gobbi, L. (2023) Trust in artificial intelligence: Global study on the shifting public perceptions of AI, KPMG, (https://assets.kpmg.com/content/dam/kpmgsites/xx/pdf/2023/09/trust-in-ai-global-study-2023.pdf.c oredownload.inline.pdf) (15.09.2024)

WHO (2021) WHO Guidance Ethics and Governance of Artificial Intelligence for Health. (https://www.who.int/publications/i/item/9789240029200) (15.09.2024).

UNESCO (2021) Recommendation on the ethics of artificial intelligence. (https://unesdoc.unesco.org/ark:/48223/pf0000380455.locale=en) (15.09.2024).

ICMRA (2021) Horizon Scanning Assessment Report – Artificial Intelligence in medicine regulation. (https://www.ema.europa.eu/en/news/artificial-intelligence-medicine-regulation) (15.09.2024).

Deloitte Touche Tohmatsu Limited (2023) Top 10 health care innovations. (https://www2.deloitte.com/us/en/pages/life-sciences-and-health-care/articles/top-10-health-care-innovations.html) (15.09.2024).

United States Cellular Corporation (USM) (2022) Top 5 AI Use Cases in Pharma & BioMedicine. (https://usmsystems.com/ai-in-pharma-and-biomedicine) (15.09.2024).